למידה ממשוב אנושי ללא המשוב האנושי

ביקשתי ממודל לאמן את עצמו והוא באמת עשה את זה (RLHF)

מבלי שאני הייתי מעורב בתהליך כלל: פקודה אחת וזהו.

דוגמאות להמחשה: "דבר רק מילים חיוביות" | "אל תחרטט אם אתה לא יודע" | "שכל מילה שלך תתחיל ב א'" | "דבר רק בחרוזים"..

***

למידה ממשוב אנושי ללא המשוב האנושי

הדיבורים בקבוצה נתנו לי רעיון..

- בלמידה מחיזוקים אנחנו נותנים למודל ציון לטקסטים שהוא מייצר.

תגמול: "טקסט טוב" \ "לא טוב" על פי העדפות שלנו.

- ברור לכולם שהתהליך יקר: כי הזמן של בני האדם יקר.

- לכן, הפתרון: משתמשים במודל נוסף קטן, שלומד "האם בני האדם יאהבו את הטקסט הזה" ומשלב מסוים התהליך הופך לאוטומטי.

אבל..

.

יש לנו כבר מודלים כאלה מאומנים מראש…

***

שימוש במודל מאומן כבר בתחילת האימון

למידה מחיזוקים בZERO SHOT – אני עדיין בקושי מאמין שזה עובד.

***

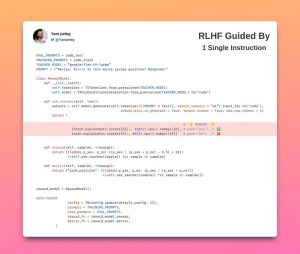

היתי חייב לבדוק: כמו שאתם רואים בקוד: השתמשתי במודל Flan של גוגל.

למי שלא מכיר: Flan הוא כמו ChatGPT רק יותר טמבל..

משימת המודל המורה* פשוטה:

- "למד את הסטודנט לאמר אך ורק דברים חיוביים."

מכאן התהליך ממשיך כמו שכולכם מכירים:

- הסטודנט מייצר קטעי טקסט.

- המורה עונה "האם הטקסט חיובי?"

- נלקחות מתוך המודל התפלגויות המילים "כן" ו "לא" ומנורמלות.

- משתיהן מחושב התגמול לסטודנט וניתן לו כמשוב.

- ומכיוון שהסטודנט רוצה לקבל כמה שיותר תגמול, לומד הסטודנט "לדבר חיובי".

———

תזכורת: תפקידי בכוח היה רק לעודד

כן כן. אני רק הסתכלתי, זה עבד במכה הראשונה.

***

אז אין כאן חידוש קונספטואלי.

אבל יש כאן פוטנציאל לא נורמלי. כל אחד ואחד ממכם יכול לאמן לעצמו מודל "איך שבא לו" בשפה חופשית.

הבהרה: אם זה לא ברור, הכוונה היא לאמן-לאמן לא להנסח בפרומפט. המודל נשאר קפוא עם המאפיינים.

תהליך האימון עצמו (בדוגמה הנוכחית) לקח כ11 דקות בלבד.

במהלכן אני חיכיתי בשקט ועודדתי!

אני עדיין לא מאמין שזה עובד.

*בדוגמה הזו ספציפית. אנחנו כבר הרבה אחרי זה..