Do Transformers Really Perform Bad for Graph Representation? (סקירה)

סקירה זו היא חלק מפינה קבועה בה אני סוקר מאמרים חשובים בתחום ה-ML/DL, וכותב גרסה פשוטה וברורה יותר שלהם בעברית. במידה ותרצו לקרוא את המאמרים הנוספים שסיכמתי, אתם מוזמנים לבדוק את העמוד שמרכז אותם תחת השם deepnightlearners.

לילה טוב חברים, היום אנחנו שוב בפינתנו deepnightlearners עם סקירה של מאמר בתחום הלמידה העמוקה. היום נבחר לסקירה המאמר שנקרא:

Do Transformers Really Perform Bad for Graph Representation?

פינת הסוקר:

המלצת קריאה מאופיר: מאמר חשוב מאוד, המספק את החיבור המתבקש בין ארכיטקטורת הטרנספורמרים שתפסה תאוצה במגוון דומיינים כגון ראייה ממוחשבת ועיבוד שפה טבעית למידע גרפי. ארכיטקטורת out-of-the-box שיכולה לשמש בבעיות גרפיות.

בהירות קריאה: גבוהה.

רמת היכרות עם כלים מתמטיים וטכניקות של ML/DL הנדרשים להבנת המאמר: נדרשת היכרות עם רשתות נוירונים גרפיות וטרנספורמרים.

יישומים פרקטיים אפשריים: כל בעיית מדעי נתונים גרפית עם דאטא רב, כאשר קיימים מספיק משאבי חישוב (בכל זאת, טרנספורמרים).

פרטי מאמר:

לינק למאמר: זמין כאן

לינק לקוד: זמין להורדה

פורסם בתאריך: 09/06/2021

הוצג בכתב העת: לא ידוע

תחומי מאמר:

- רשתות נוירונים גרפיות.

- טרנספורמרים.

כלים מתמטיים, טכניקות, מושגים וסימונים:

מבוא והסבר כללי על תחום המאמר:

ארכיטקטורת הטרנספורמרים צוברת פופולריות רבה בכמה מהתחומים הגדולים במדעי הנתונים – ראייה ממוחשבת, שפה טבעית וזיהוי דיבור. עם זאת, עד הוצאת המאמר לא הצליחו להחיל את הארכיטקטורה על מידע גרפי בהצלחה. במאמר זה הכותבים הצליחו לעשות זאת.

תמצית המאמר:

במאמר זה הכותבים ממייקרוסופט מציגים את ארכיטקטורת ה-Graphormer, אשר מהווה את ההתאמה של טרנספורמרים למידע גרפי. עד כתיבת המאמר, ההתאמה של טרנספורמרים למידע גרפי גררה שימוש ב- softmax attention בלבד, שהגבילה את הגמישות הרשת, אשר נדרשת במיוחד בבעיות גרפיות. בנוסף, הכותבים מראים שארכיטקטורת ה-Graphormer מהווה את המקרה הכללי עבור מגוון ארכיטקטורות קודמות של רשתות נוירונים גרפיות.

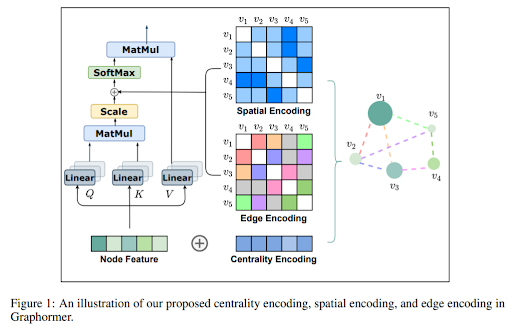

אילוסטריצה של ה-attention ב-Graphormer:

כעת, נרחיב על החלקים הייחודיים בארכיטקטורה – קידודי המרכזיות, המרחב והקשתות.

קידוד מרכזיות (Centrality Encoding)

קידוד המרכזיות עבור קודקוד מתבצע בעצם על ידי חיבור של שני וקטורים למידים המהווים פונקציה על גבי דרגות הכניסה והיציאה של הקודקוד.

קידוד המרחב (Spatial Encoding)

קידוד המרחב הוא פונקציה סקלרית למידה על גבי המרחק המינימלי בין כל שני קודקודים, והוא משותף בין שכבות הטרנספורמר. במידה ואין מסלול בין שני הקודקודים, ערך דיפולטי נבחר.

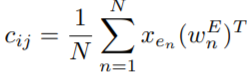

קידוד הקשתות (Edge Encoding)

פה מדובר ברעיון חדש שעוד לא בדיוק החלטתי מה אני חושב עליו, בגלל מימד רנדומליות שנכנס בו – ועשוי להקשות בגרפים גדולים.

מייצרים קידוד קשת בין כל שני קודקודים גם אם אין קשת ישירה ביניהם. ראשית, לוקחים את אחד המסלולים הקצרים ביותר ביניהם (מה שמכניס מימד של אקראיות). כעת, מחשבים את ממוצע מכפלת התכונות של הקשת במטריצת משקול נלמדת לכל מיקום בסדר (משקול לקשתות הראשונות במסלול, השניות וכך הלאה).

סיכום ה-Attention (הרב-ראשי)

שכבת Graphormer שלמה

מבנה השכבה הכללי כולל:

- מבנה טרנספורמר עדכני עם attention רב-ראשי הפועל על על נרמול השכבה הקודמת ו-skip-connection.

- לאחריו, רשת נוירונים feedforward הפועלת על נרמול תוצאת הביניים, בנוסף לעוד skip connection.

קודקוד וירטואלי

בנוסף לכל זאת, הכותבים משתמשים ברעיון של קודקוד וירטואלי עם קשתות נכנסות מכל הקודקודים בגרף שישמור ייצוג לגרף כולו בדומה לcls בטרנספורמר המקורי.

דאטא:

הכותבים בחנו את יעילות הארכיטקטורה במגוון benchmarks גרפיים:

- OGB-LSC – אתגר רגרסיה של כימיה קוונטית עם 3.8 מיליון גרפים.

- OGBG-MOLHIV – מאגר תכונות מולקולריות.

- OGBG-MOLPCBA – גם מאגר תכונות מולקולריות, אבל גדול יותר.

- ZINC – מאגר תכונות ביולוגיות של מולקולות.

הישגי המאמר:

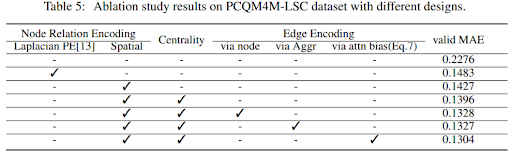

Graphormer מציג את התוצאות הטובות ביותר בכל המאגרים שצוינו, בפער ניכר ומשמעותי מבחינה סטטיסטית. בנוסף הכותבים עשו מחקר אבלציות על מנת להראות שכל חלקי הארכיטקטורה רלוונטיים:

נ.ב.

שניים מהכותבים מצוינים בתור מתמחים בחברה. סחתיין למייקרוסופט על שילוב במחקר בסדר גודל כזה.

הפוסט נכתב על ידי אופיר יזרעאלב.

אופיר עובד ב-Dell EMC בתור data scientist במקביל ללימודי תואר שני בדאטא סיינס וביואינפורמטיקה באוניברסיטת בן גוריון. בנוסף לעבודת הדאטא סיינס, אופיר עוסק בכתיבת פטנטים וקידום חדשנות תאגידית בתחום.